Nel mondo dell’intelligenza artificiale, l’inferenza è il processo attraverso il quale un modello AI risponde a una domanda o genera un contenuto, come un’immagine, a partire da un input specifico.

In pratica, l’intelligenza generata dai modelli linguistici di grandi dimensioni (LLM) è costruita attraverso una sequenza di “token”, che rappresentano unità di informazione.

Questi “token” sono il prodotto finale di un processo chiamato inferenza AI, ma le cose si complicano quando parliamo di agenti AI, che non si limitano a dare risposte singole, ma suddividono i compiti in una serie di inferenze successive.

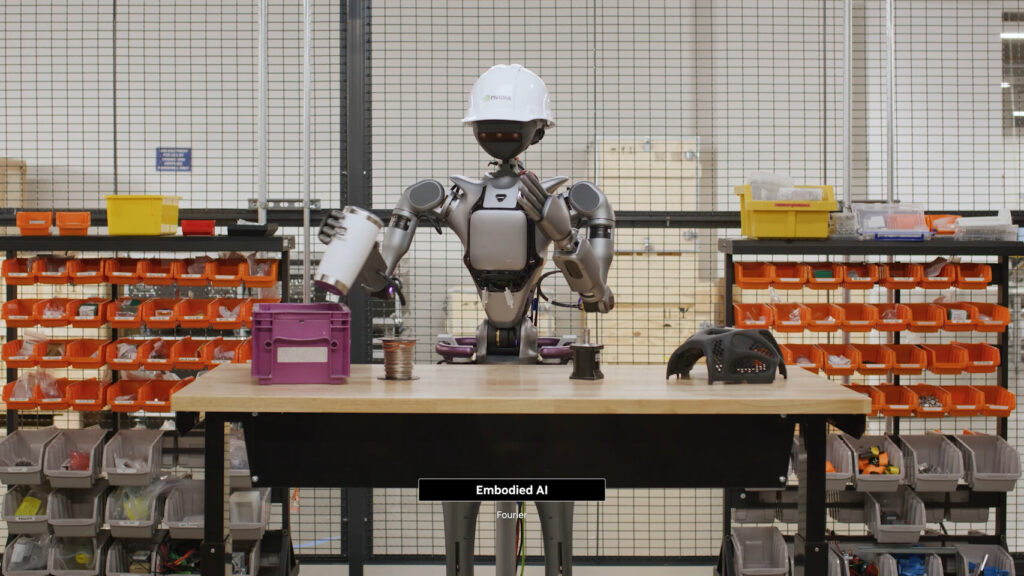

Ecco dove entrano in gioco le AI Factory di NVIDIA, la piattaforma che ottimizza le prestazioni di inferenza su larga scala, rendendo possibili progressi industriali senza precedenti.

Cosa Sono le AI Factory?

Le AI Factory sono infrastrutture massicce che alimentano il processo di inferenza AI, servendo milioni di utenti contemporaneamente. In questi ambienti, il “prodotto” generato sono i token AI, che si traducono in intelligenza.

Nell’era dell’intelligenza artificiale, la generazione di intelligenza è ciò che alimenta la crescita economica: più efficienza nella gestione e nell’elaborazione dei workload di AI porta a maggiori ricavi e profitti.

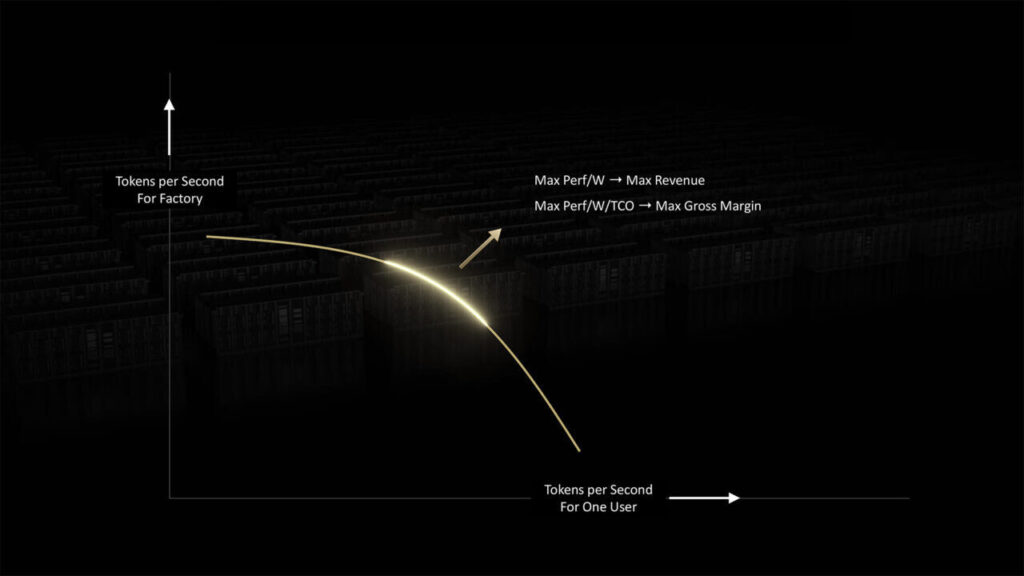

Ma la vera sfida è come ottimizzare questa crescita, bilanciando le esigenze di velocità per utente e capacità complessiva di sistema.

Ottimizzare l’Inferenza AI: Velocità vs Throughput

Il bilanciamento tra velocità e throughput è fondamentale per il successo delle AI Factory. Per ottenere prestazioni ottimali, queste infrastrutture devono gestire una grande varietà di carichi di lavoro, ciascuno con proprie richieste di performance.

Le AI Factory possono migliorare questi fattori scalando l’hardware: aumentando le FLOPS (operazioni in virgola mobile al secondo) e la larghezza di banda. Più si scalano questi parametri, più il sistema diventa produttivo. Tuttavia, una volta che l’hardware raggiunge un limite di potenza disponibile, i progressi si fermano, ed è qui che entra in gioco l’innovazione nelle architetture.

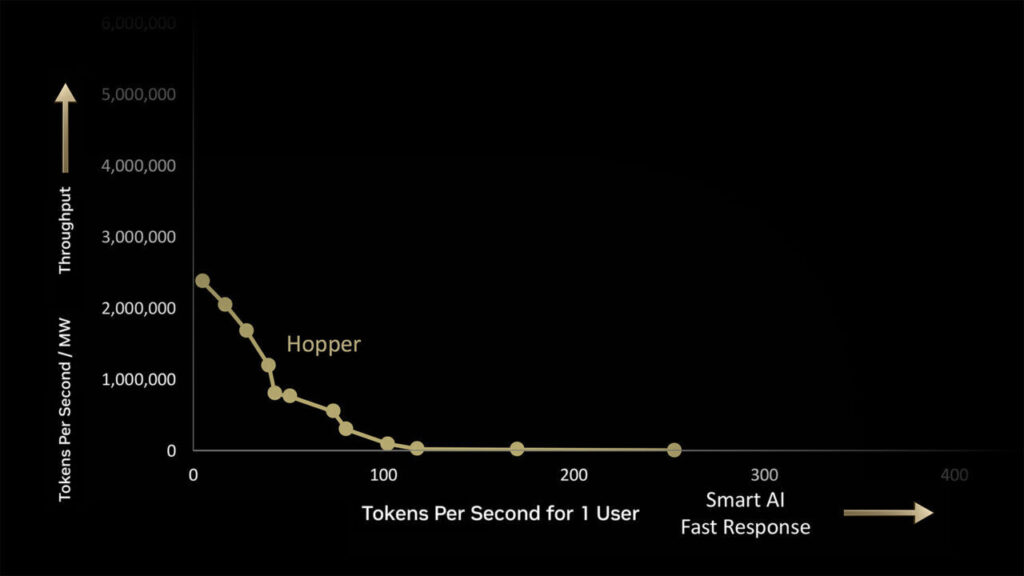

NVIDIA Hopper vs Blackwell: Una Generazione di Differenza

Le architetture GPU di NVIDIA giocano un ruolo cruciale nell’ottimizzazione delle AI Factory. Nel caso di una AI Factory da 1 megawatt, l’architettura NVIDIA Hopper è in grado di generare fino a 180.000 token al secondo (TPS), raggiungendo un massimo di 225 TPS per utente. Tuttavia, l’innovazione principale non sta solo nei numeri, ma nel modo in cui il carico di lavoro viene distribuito e processato nel tempo, con ciascun punto lungo la curva che rappresenta un lotto di inferenze da eseguire.

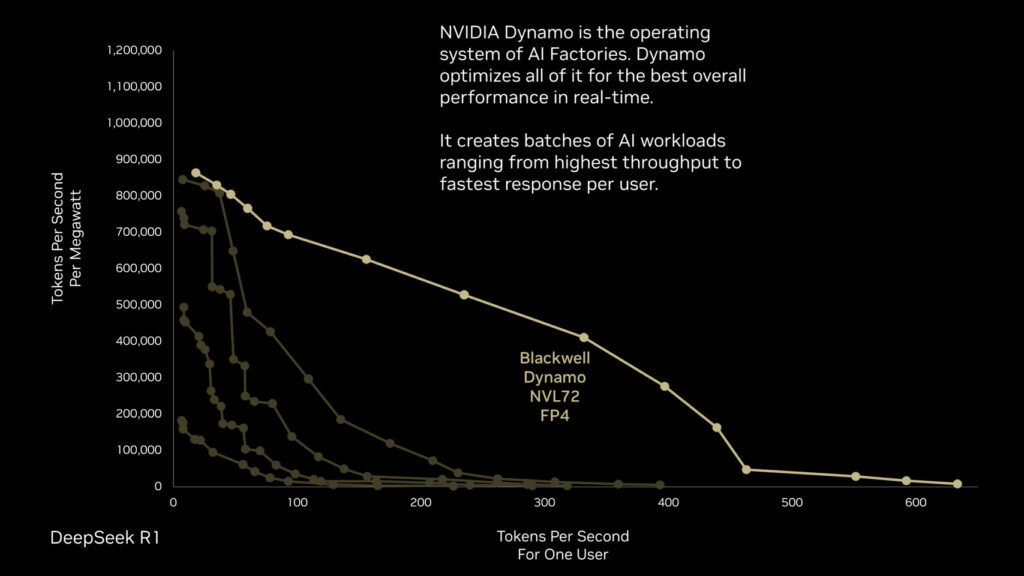

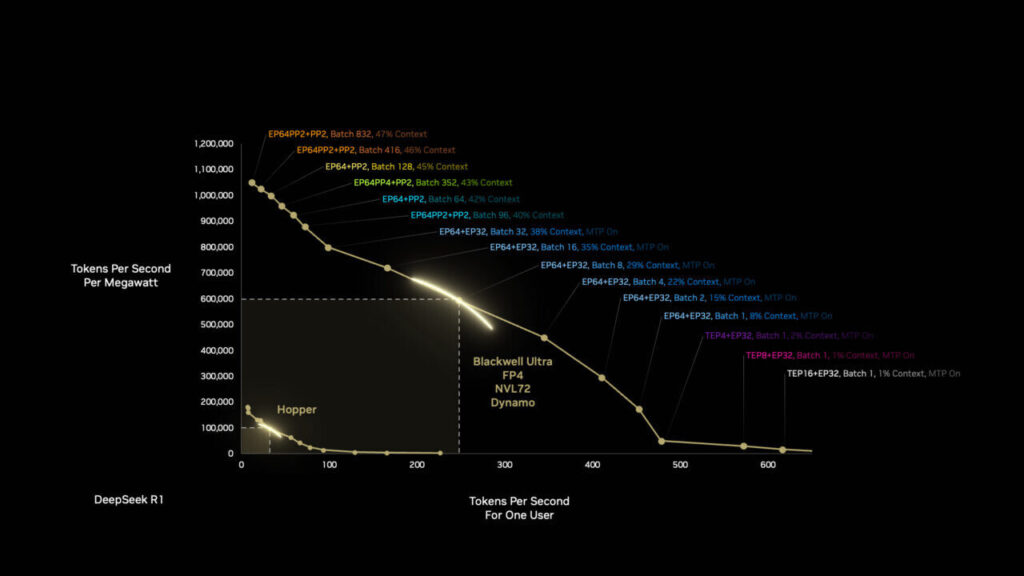

La vera svolta avviene con l’architettura NVIDIA Blackwell, che ottimizza l’efficienza energetica e le prestazioni per unità di energia. Con la stessa potenza di 1 megawatt, Blackwell riesce a ottenere 50 volte più prestazioni in AI reasoning rispetto a Hopper.

Questo salto generazionale è il risultato di un’innovazione a livello hardware e software, dove ogni componente è progettato per lavorare insieme in modo estremamente efficiente. Blackwell non è solo una nuova architettura: è il risultato di un’intera stack di software e hardware ottimizzati, come dimostrato dal sistema NVIDIA Dynamo.

NVIDIA Dynamo: L’Intelligenza al Servizio dell’Inferenza

Dynamo è il nuovo sistema operativo per AI Factory, pensato per ottimizzare in tempo reale i workload, ripartendo dinamicamente i compiti tra le risorse computazionali disponibili. Questo approccio permette alle AI Factory di “aggiornarsi” autonomamente e migliorare la distribuzione delle risorse per garantire il miglior risultato possibile in ogni fase dell’elaborazione.

La vera innovazione sta nel fatto che Dynamo non è solo un sistema operativo: è un’intelligenza autonoma che ottimizza e migliora continuamente le prestazioni, massimizzando l’efficienza anche nei periodi di picco di carico di lavoro.

Impatti Real-World e le Prospettive Future

Il miglioramento delle prestazioni dell’AI Factory non si limita alla generazione di token più rapida. Con un incremento continuo delle prestazioni per watt di energia consumato, il passaggio dalla generazione Hopper a Blackwell apre nuove frontiere in vari settori. Ad esempio, AI reasoning può accelerare enormemente le applicazioni industriali e scientifiche, portando ad avanzamenti straordinari nel trattamento di malattie, nella lotta contro i cambiamenti climatici e nella scoperta dei segreti dell’universo.

Ogni salto generazionale nell’architettura e nell’ottimizzazione del software non è solo una vittoria tecnologica, ma anche un passo avanti per l’economia globale, dove il capitale prodotto dall’informatica AI ha il potenziale per creare trilioni di dollari di produttività. Con ogni nuova generazione di hardware e software, le AI Factory non solo migliorano le prestazioni, ma rendono l’intelligenza artificiale una risorsa economica centrale, capace di alimentare la prossima rivoluzione industriale.

Conclusioni: AI, Potenza e Capitale

In un mondo in cui l’intelligenza artificiale sta diventando il motore principale per l’innovazione industriale, la piattaforma AI Factory di NVIDIA è la chiave per garantire che le prestazioni rimangano elevate, ma con una gestione ottimizzata dell’energia. L’industria della AI sta diventando più potente ed efficiente, e con l’adozione di Blackwell e Dynamo, il futuro sembra pronto ad aprire nuove porte in termini di produttività e impatti reali sulla società.

L’intelligenza computazionale si trasforma in capitale, e il progresso diventa il nostro nuovo punto di partenza.

HW Legend Staff

![Kingston FURY Renegade G5 NVMe M.2 SSD 2TB [SFYR2S/2T0] Cop - Kingston FURY Renegade G5 NVMe M.2 SSD 2TB [SFYR2S2T0]](https://www.hwlegend.tech/wp-content/uploads/2025/10/Cop-Kingston-FURY-Renegade-G5-NVMe-M.2-SSD-2TB-SFYR2S2T0-150x150.webp)