Intel ha annunciato un importante aggiornamento per Project Battlematrix, l’iniziativa presentata a maggio durante il Computex 2025 e pensata per accelerare l’adozione di carichi AI attraverso workstation scalabili e accessibili.

Con questo progetto, Intel mira a consolidare il proprio posizionamento nell’ambito dell’AI inference, grazie all’integrazione ottimizzata delle GPU Intel Arc Pro B-series “Battlemage” tramite un nuovo stack software specializzato.

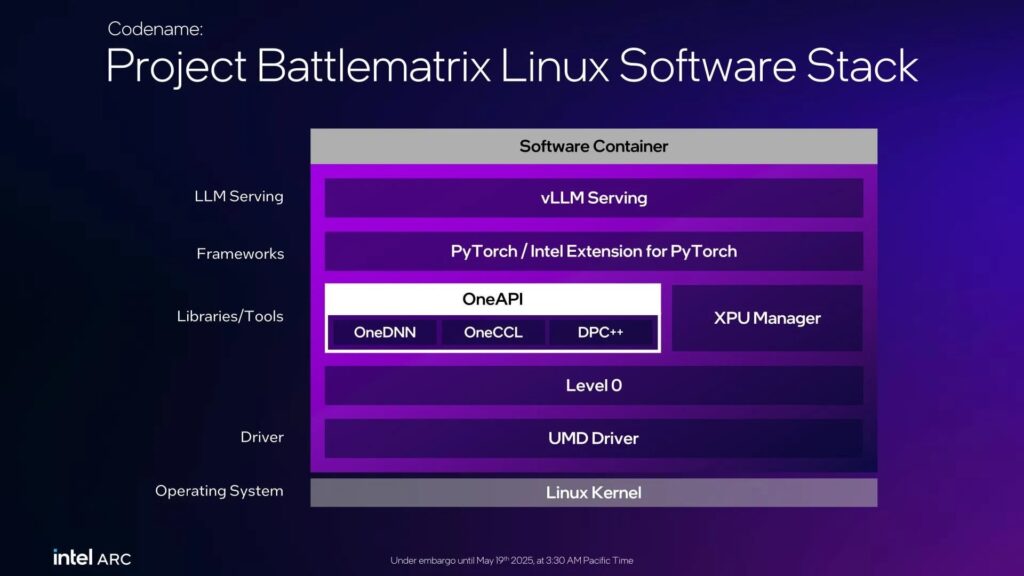

Battlematrix: AI semplificata e scalabile per Linux

Il cuore del progetto è uno stack software containerizzato, progettato per ambienti Linux, che punta su tre direttrici principali:

Intuitività d’uso per gli utenti finali;

Conformità agli standard di settore;

Performance elevate con supporto multi-GPU.

A livello enterprise, Battlematrix include funzionalità avanzate di affidabilità come ECC, SR-IOV (Single-Root I/O Virtualization), telemetria in tempo reale e aggiornamenti firmware da remoto. Questo lo rende una soluzione completa per sviluppatori e aziende che operano con carichi AI intensivi.

Novità: LLM Scaler v1.0 – Container per inferenza AI ad alte prestazioni

Il rilascio di oggi riguarda la versione 1.0 del container LLM Scaler, che segna un passaggio fondamentale verso l’adozione anticipata da parte del mondo business. Basato sul framework vLLM, questo container offre:

Fino a 1.8x di miglioramento nel throughput (token-per-output-per-second, TPOP) su modelli da 32B KPI con input superiori a 4K token;

Fino a 4.2x di guadagno su modelli da 70B KPI con sequenze lunghe fino a 40K token;

+10% di throughput medio su modelli tra 8B e 32B KPI, rispetto alle versioni precedenti.

Tra le principali ottimizzazioni tecniche:

Quantizzazione online layer-by-layer per ridurre l’utilizzo di memoria GPU;

Supporto sperimentale a pipeline parallelism (PP);

Integrazione con torch.compile;

Speculative decoding per migliorare la latenza inferenziale.

Espansione della compatibilità e gestione hardware avanzata

La nuova release amplia la compatibilità del container anche a:

Modelli embedding e di re-ranking;

Modelli multimodali con supporto migliorato;

Rilevamento automatico della lunghezza massima di input;

Supporto per data parallelism;

Tool di benchmark basati su OneCCL.

In parallelo, Intel introduce XPU Manager, un set di strumenti per:

Gestione energetica delle GPU;

Aggiornamenti firmware automatizzati;

Diagnostica approfondita;

Monitoraggio della banda di memoria.

Roadmap: rilascio completo entro fine anno

Secondo Intel, questa versione è in linea con la roadmap presentata a maggio. Una versione LLM Scaler “hardened”, con ulteriori funzionalità e stabilità migliorata, è prevista per la fine del terzo trimestre 2025, mentre la release completa full-feature arriverà nel quarto trimestre, completando l’offerta AI di Intel per l’ambiente professionale.

Dove scaricare

La versione 1.0 del LLM Scaler container è già disponibile per il download dal sito ufficiale Intel.

HW Legend Staff

![Kingston FURY Renegade G5 NVMe M.2 SSD 2TB [SFYR2S/2T0] Cop – Kingston FURY Renegade G5 NVMe M.2 SSD 2TB [SFYR2S2T0]](https://www.hwlegend.tech/wp-content/uploads/2025/10/Cop-Kingston-FURY-Renegade-G5-NVMe-M.2-SSD-2TB-SFYR2S2T0-150x150.webp)