ASUS, l’azienda IT leader nei sistemi server, schede madri per server e workstation, ha pubblicato per la prima volta i propri risultati da quando è entrata a far parte della MLCommons Association lo scorso dicembre. E ha stabilito fin da subito nuovi record di prestazioni in dozzine di benchmark.

Nello specifico, durante l’ultimo round di MLPerf Inference 2.0 i server ASUS hanno stabilito 26 record nella divisione Data Center Closed in sei attività di benchmark AI, superando tutti gli altri server con le stesse configurazioni GPU. Il risultato è stato ottenuto con 12 record raggiunti da un server ASUS ESC8000A-E11 configurato con otto GPU NVIDIA® A100 Tensor Core da 80 GB. Altri 14 record sono arrivati da un server ASUS ESC4000A-E11 con quattro GPU NVIDIA A30 Tensor Core da 24 GB.

Modern interior server room data center. Connection and cyber network in dark servers. Backup, mining, hosting, mainframe, farm, cloud and computer rack with storage information. Close up,3D rendering; Shutterstock ID 1717870396; purchase_order: -; job: -; client: -; other: –

Questi risultati rivoluzionari dimostrano l’assoluto predominio in termini di prestazioni dei server ASUS nell’arena dell’AI, in grado di offrire un significativo valore aggiunto alle aziende, agli enti e alle società che necessitano di implementazioni AI-based e garantire prestazioni ottimali per i data center.

ASUS ha stabilito 26 record nell’inferenza AI e domina le tabelle dei risultati in sei attività

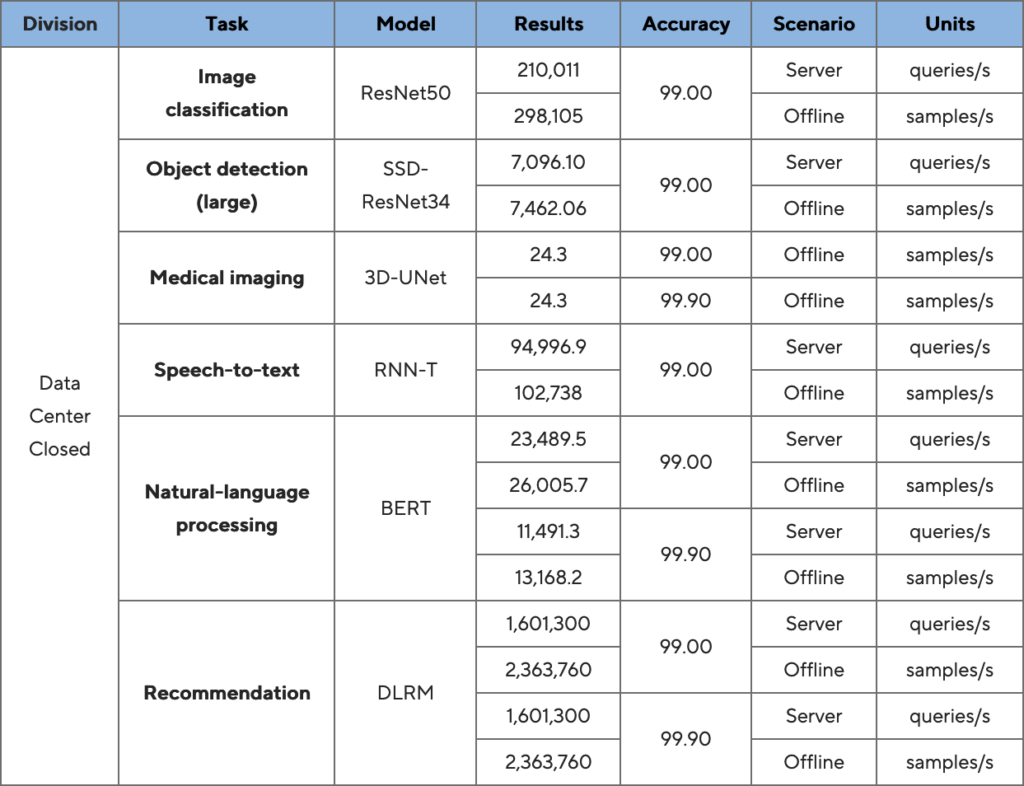

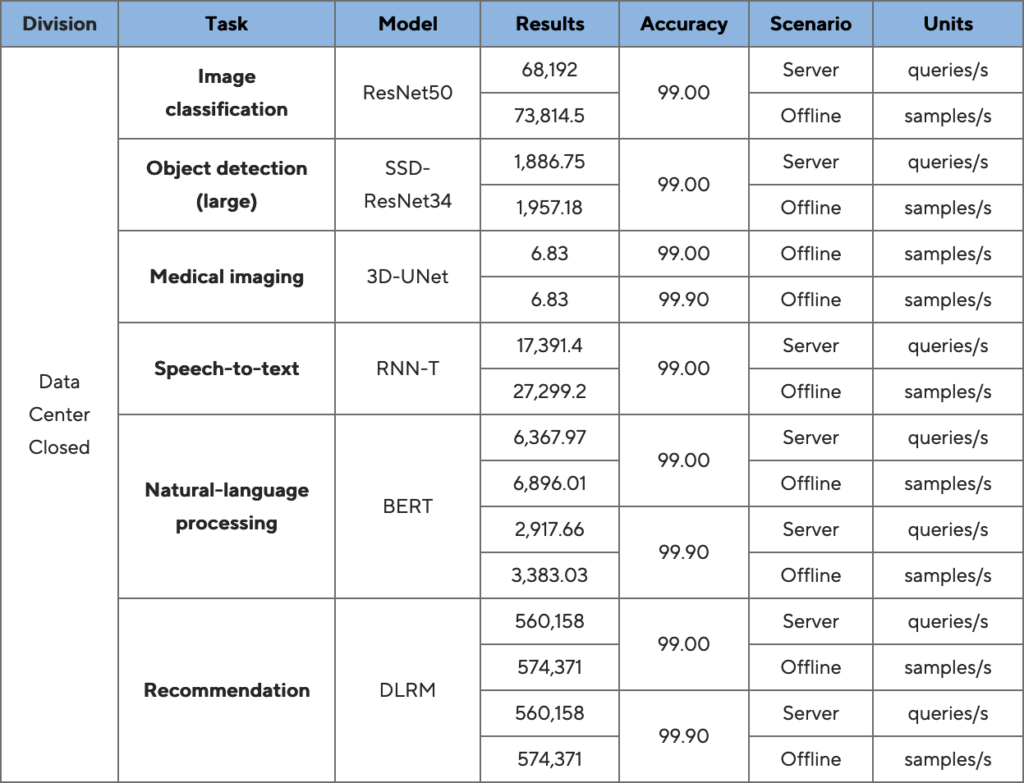

Il benchmark MLPerf Inference 2.0 simula sei comuni processi di calcolo inferenziale AI, tra cui la classificazione delle immagini (ResNet50), il rilevamento di oggetti (SSD-ResNet34), la segmentazione delle immagini mediche (3D-Unet), il riconoscimento vocale (RNN-T), l’elaborazione del linguaggio naturale (BERT) e la sua raccomandazione (DLRM).

L’ASUS ESC8000A-E11 ha ottenuto diverse posizioni di leadership sulle prestazioni, tra cui:

- Classificazione di immagini con 298.105 immagini elaborate al secondo in ResNet50;

- Riconoscimento degli oggetti con 7.462,06 immagini completate al secondo in SSD-ResNet34;

- Elaborazione di immagini mediche con 24,3 immagini processate al secondo in 3D-UNet;

- Completate 26.005,7 domande e risposte processate al secondo in BERT;

- Completate 2.363.760 previsioni di clic al secondo in DLRM.

Risultati tabella ESC8000A-E11

L’ASUS ESC4000A-E11 ha ottenuto a sua volta posizioni di vertice nelle prestazioni in diversi ambiti, tra cui:

- Classificazione di immagini con 73.814,5 immagini elaborate al secondo in ResNet50;

- Riconoscimento degli oggetti con 1.957,18 immagini completate al secondo in SSD-ResNet34;

- Elaborazione di immagini mediche con 6,83 immagini processate al secondo in 3D-UNet;

- Completate 27.299,2 conversioni di riconoscimento vocale al secondo in RNNT;

- Completate 6.896,01 domande e risposte al secondo in BERT;

- Completate 574.371 previsioni di clic al secondo in DLRM.

Risultati tabella ESC40001-E11

Miglioramento costante delle prestazioni AI grazie al design del server ottimizzato

La dozzina di record MLPerf Inference 2.0 stabiliti dal server ASUS 4U ESC8000A-E11 certificato NVIDIA e configurato con otto GPU NVIDIA A100 PCIe Tensor Core da 80 GB e due CPU AMD EPYC 7763, dimostra la sua eccezionale scalabilità per applicazioni che coinvolgono l’intelligenza artificiale e l’apprendimento automatico. Il suo design termico ottimizzato, con tunnel per il flusso d’aria indipendenti per CPU e GPU, offre soluzioni di raffreddamento ad alta efficienza ai data center raffreddati ad aria.

L’ASUS ESC4000A-E11 che ha stabilito un totale di 14 record MPLerf Inference 2.0 è un server certificato NVIDIA, alloggiato nel formato 2U più compatto del mercato e configurato con quattro GPU NVIDIA A30 PCIe Tensor Core da 24 GB e due CPU AMD EPYC 7763. Offre un’ampia gamma di acceleratori grafici, oltre al supporto per l’interconnessione GPU ad alta velocità NVIDIA NVLink, per esprimere le massime prestazioni in ambito AI.

HW Legend Staff